自1956年提出AI概念,至今AI技术不断突破与发展,AI芯片不断升级优化。从广义上讲能够运行处理人工智能应用中大量计算任务芯片的都为AI芯片,狭义上来讲AI芯片指的是针对人工智能算法做了特殊加速设计的芯片。

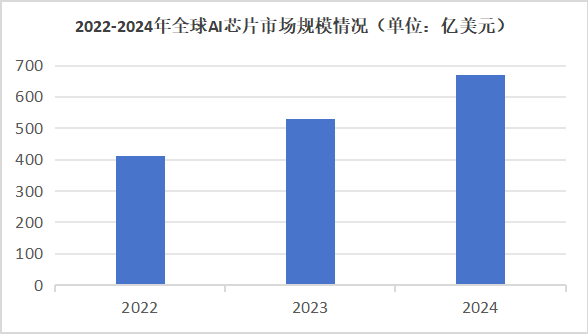

如下图为2022至2024年全球AI芯片市场规模情况统计,数据显示,2022年全球AI芯片市场规模约为441.7亿美元,预计到2024年将达到671亿美元,年均复合增长率达到15%。预计在未来几年全球AI芯片市场规模将会持续扩大。

在科技日新月异的今天,AI已经成为时代发展的最强音,为了让AI技术更好地服务于人类,一款强大的硬件载体至关重要。在此之前,让我们回顾一下传统处理器的构成框架与发展历程。

中央处理器(CPU)

CPU,计算机的核心,英文全称Central Processing Unit。

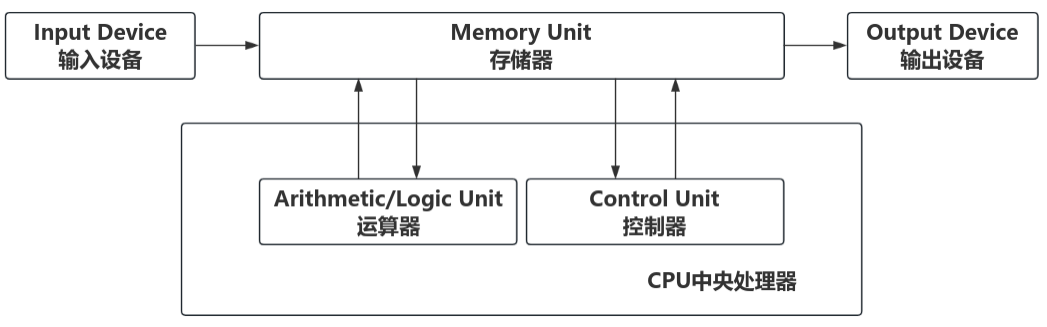

现代计算机发展所遵循的基本结构形式始终是冯·诺依曼机结构,需要CPU从存储器取出指令和数据进行相应的计算,CPU负责承担运算器和控制器这两个核心功能。

冯诺伊曼架构

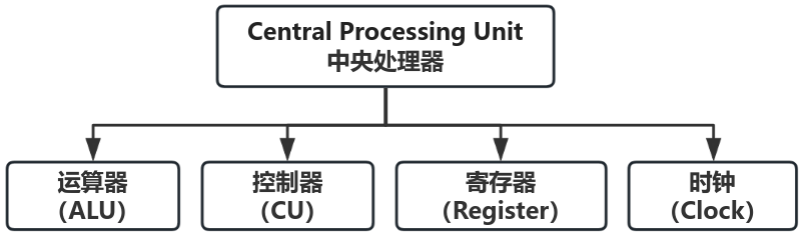

CPU通常由运算器、控制器、时钟、寄存器等多个模块构成。

运算器是CPU的核心部件,用于执行算术和逻辑运算。它包括加法器、减法器、乘法器、除法器等,可以对数字进行加减乘除等运算。

控制器负责从内存中读取指令,解码并执行指令。它通过控制时序信号和地址总线等与其他模块进行协调,确保正确地执行指令。

寄存器是CPU中的高速存储器,用于暂时保存指令和数据。

时钟模块负责管理CPU的时间,为CPU提供稳定的时基。它通过周期性地发出信号来驱动CPU中的所有操作,调度各个模块的工作。

CPU的主要功能是执行指令并控制计算机操作,共有三个关键阶段:提取,解码和执行。它可以执行各种类型的指令包括数据操作、逻辑判断、存取内存、中断处理等。

CPU工作运行原理:取指-译码-执行-访存-写回。

CPU从cache或主存中取出指令,然后放入指令寄存器,控制器对该指令进行译码,最终把指令分解成一系列的微操作,然后发出各种控制命令,执行微操作序列,从而完成一条指令的执行。

总的来说,CPU的发展历程可以说是Intel和AMD的发展史。1971年,Intel公司推出世界上第一个CPU——4004,并在各时期逐步发展壮大,成为CPU领域的领军人物。面对Intel的强大压力,AMD并没有放弃,反而积极寻求突破,通过引入先进的技术,不断改进产品设计,最终在CPU市场上站稳了脚跟。

如今,国内外各大科技公司纷纷布局AI芯片领域,力求在这场科技竞赛中抢占先机。我国政府也对AI芯片产业给予了高度重视,出台了一系列政策扶持措施,加快了这个产业的蓬勃发展。在这个风起云涌的AI时代,谁掌握了AI芯片技术,谁就拥有了开启未来智能世界的钥匙。接下来,让我们一起来揭开它神秘的面纱,探寻其中的奥秘。

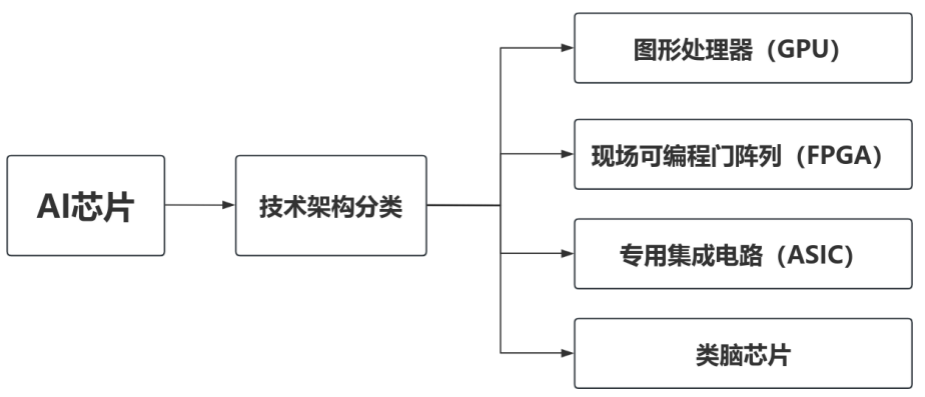

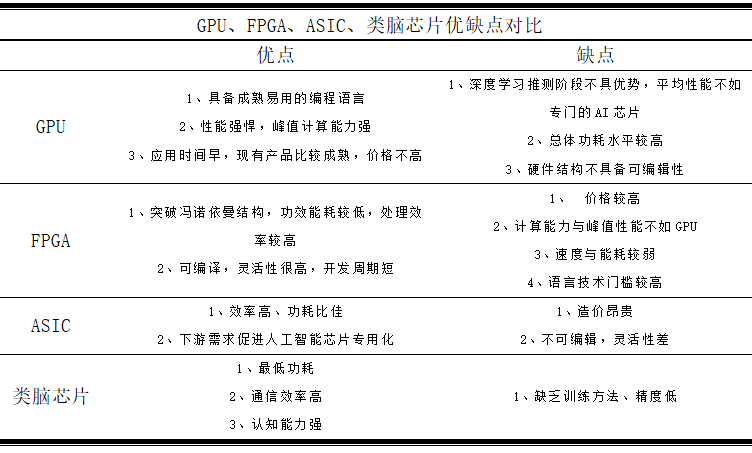

AI芯片按照技术架构分类主要为图形处理器(GPU)、现场可编程门阵列(FPGA)、专用集成电路(ASIC)与类脑芯片;

AI芯片分类框架

图形处理器(GPU)

GPU,显卡的核心,英文全称Graphics Processing Unit。

CPU的定位是通用计算芯片,而GPU的定位是并行计算芯片,主要是将其中非常复杂的数学和几何计算抽出,变成一个超高密度、能够并行计算的方式。

CPU与GPU构架对比

GPU早期是为了图形渲染而设计,后来GPU在设计上走向了通用计算。GPU 的工作方式与CPU类似——它以极快的速度执行计算。GPU 的主要工作是进行与图形相关的计算,以便CPU可以继续处理其他所有事情,由于它是一个独立的芯片,它可以与CPU同时执行计算,从而为其他任务腾出处理能力。目前,GPU已经发展到较为成熟的阶段,谷歌、 FACEBOOK、微软、 Twtter和百度等公司都在使用GPU分析图片、视频和音频文件,以改进搜索和图像标签等应用功能。

真正意义上的第一款GPU是英伟达在1999年发布的Geforce 256。

2022年3月,英伟达在GPU技术大会上发布了基于新一代Hopper架构的高性能GPU芯片H100。对于追求极致效率的大模型训练需求,H100往往是最优解,因为它具有更好的可扩展性,能够更快地完成训练,缩短启动、训练或改进模型所需的时间,对于初创公司来说非常重要。因此,它受到许多公司的广泛青睐。

NVIDIA H100

GPU的优势在于提供了多个核心的并行计算基础结构,具备处理大量数据和高性能浮点运算的能力。然而,GPU也存在一定的限制。在深度学习算法中,训练和推断是两个不同的阶段。GPU平台在训练阶段效率非常高,但在进行单个输入项的推断时,并行计算的优势并不能完全发挥出来。

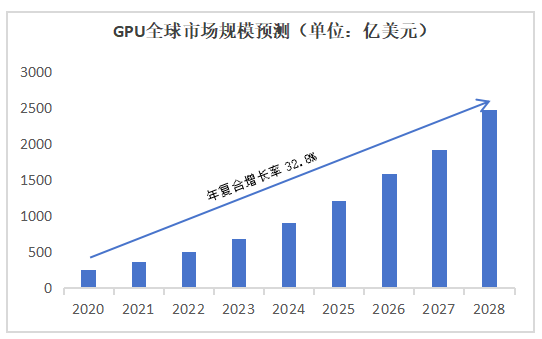

如下图为2020至2028年GPU全球市场规模预测情况,根据Verified Market Research的预测,2020年GPU全球市场规模为254亿美金,预计到2028年将达到2465亿美金,行业保持高速增长,复合年均增长率为32.8%。

2020-2028年GPU全球市场规模预测柱状图

现场可编程门阵列(FPGA)

FPGA(Field Programmable Gate Array)是在PAL (可编程阵列逻辑)、GAL(通用阵列逻辑)等可编程器件的基础上进一步发展的产物。它是作为专用集成电路(ASIC)领域中的一种半定制电路而出现的,既解决了定制电路的不足,又克服了原有可编程器件门电路数有限的缺点。

FPGA能够同时实现数据并行和任务并行计算,这在处理特定应用时能够显著提升效率。与通用CPU相比,通用CPU可能需要多个时钟周期才能完成特定运算,而FPGA可以通过编程重组电路,直接生成专用电路,这样就能在仅消耗少量甚至一次时钟周期的情况下完成运算。

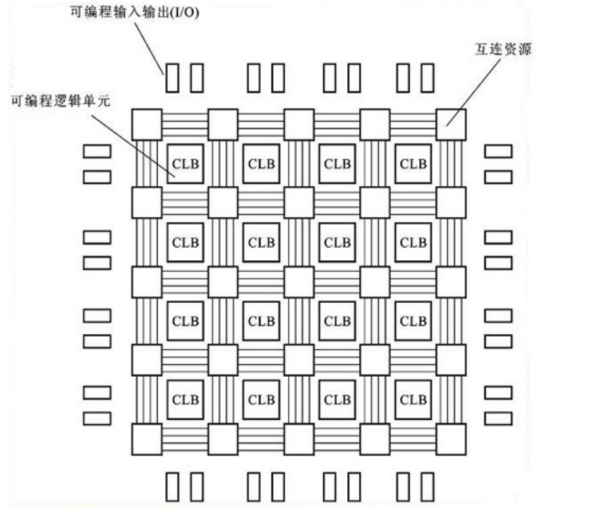

FPGA基本架构

FPGA由可编程逻辑块(CLB)、输入/输出模块(IOB)、可编程互连资源(PIR)等三种可编程电路和用于存放编程数据的静态存储器SRAM组成。CLB是实现逻辑功能的基本单元,它们通常按照规则排列在一个阵列中,散布于整个芯片中。IOB主要负责芯片上的逻辑与外部引脚的接口,通常排列在芯片的四周。PIR则提供丰富的连线资源,包括纵横网状连线、可编程开关矩阵和可编程连接点等,用于将各个CLB、CLB与IOB以及IOB连接起来,构成特定功能的电路。静态存储器SRAM用于存储内部IOB、CLB和PIR的编程数据,并用于对IOB、CLB和PIR进行控制,以实现系统逻辑功能。

由于FPGA具有可编程灵活性高、开发周期短以及并行计算效率高等特点,FPGA的应用场景非常广泛,遍布航空航天、汽车、医疗、广播、测试测量、消费电子、工业控制等热门领域。

专用集成电路(ASIC)

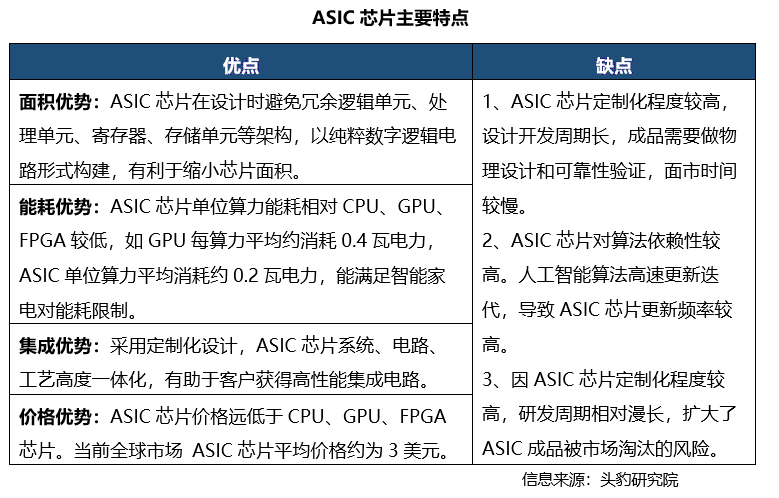

ASIC (Application Specific Integrated Circuit )芯片是专用集成电路,是针对用户对特定电子系统的需求,从根级设计、制造的专有应用程序芯片,其计算能力和计算效率可根据算法需要进行定制,是固定算法最优化设计的产物。定制化特性可以提高ASIC的性能功耗比,尤其在高性能、低功耗和移动应用方面具有明显优势。然而,缺点包括定制化程度较高、设计周期长、算法依赖性高和扩展性差等。

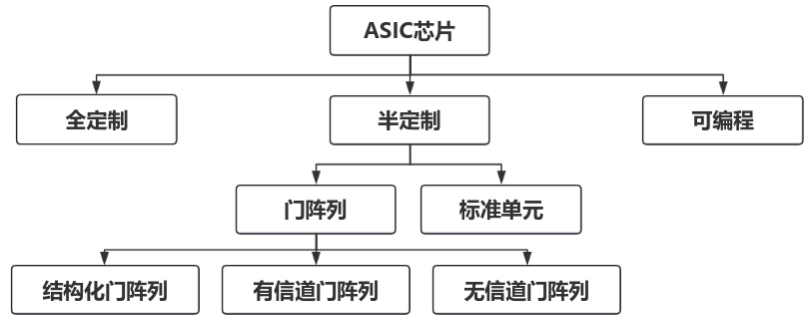

据定制程度不同,ASIC 芯片可被分为全定制ASIC 芯片、半定制ASIC 芯片及可编程ASIC芯片。

ASIC芯片分类框架

ASIC芯片在芯片行业正在受到重视,可根据终端功能不同分类为TPU、DPU、NPU。TPU为张量处理器,专用于机器学习;DPU为数据中心等计算场景提供计算引擎;NPU是神经网络处理器,在电路层模拟人类神经元和突触,并用深度学习指令集处理数据。

谷歌为ASIC芯片的先驱,于16年发布第一代TPU(ASIC)产品,17年发布TPU v2,21年发布TPU v4;英特尔在19年底收购以色列人工智能芯片公司Habana Labs,22年发布Gaudi 2 ASIC芯片。目前,ASIC在通信领域、图像与视频处理、汽车电子、医疗设备、人工智能等领域都有广泛应用。

当ASIC在解决特定问题时表现出色时,它打开了许多新领域,推动了科技的进一步进步。随着ASIC不断发展,集成电路设计和制造技术也得到了不断提高,这促进了整个行业的创新和提升。

类脑芯片

类脑计算芯片(Neuro-inspired computing chips)就是用电路模拟人脑神经网络架构的芯片,它结合微电子技术和新型神经形态器件,模仿人脑神经系统计算原理进行设计,实现类似人脑的超低功耗和并行信息处理能力。利用类脑计算的优点,我们可以有效处理那些无法按照传统方式组织的信息,同时它也有助于建立机器学习的内部模式,此外还可能产生创新思维并孕育新型AI,为通向通用人工智能铺平道路。

类脑芯片将数字处理器视为神经元,将内存作为突触,与传统冯诺依曼架构不同,它的内存、CPU和通信部件完全集成在一起。因此,信息的本地处理得以实现,并且由于处理的数据量不大,该架构可以克服传统计算机内存和CPU之间的速度瓶颈问题。

当前,典型的类脑计算芯片有清华大学类脑计算研究中心施路平教授的团队成功开发出全球首款异构融合类脑计算芯片——天机Tianjic芯片,该芯片的创新之处在于结合了SNN和ANN两种算法,能够提供混合和协同的平台,支持异构网络的混合建模,并形成协调的时空域调度系统,它可以发挥不同算法的优势,既能降低能耗,又能提高速度,同时还能够保持高准确度;英特尔Loihi芯片采用了神经拟态架构,超越了传统计算机架构的限制,模糊了内存和处理之间的边界。和人类大脑类似,它利用数据连接、数据编码和电路活动的各种形式来实现处理,二者同步进行。

作为新一代的人工智能处理器,类脑芯片具有并行计算、低功耗设计和自适应学习等特点,为人工智能领域带来了许多新的机遇。目前,在模式识别与图像处理、自动机器人、大数据分析、医学与生物科学研究等领域,类脑芯片具有巨大的潜力,将推动人工智能技术的更大突破和进步。

随着人工智能技术的飞速发展,AI芯片的技术架构也在不断演进和升级。本篇从AI芯片的技术架构分类来看,我们可以了解到CPU、GPU、FPGA、ASIC以及类脑芯片等不同的芯片技术选择,这些技术架构不仅在性能上有着显著的优势,同时也为人工智能应用提供了更广阔的发展空间。人工智能技术的发展不仅仅是技术进步的问题,更是一种思维方式的变革,它让我们重新审视自己的思考方式,思考如何利用科技来提高我们的生产力和生活质量,我们期待着这个领域的未来发展,并坚信它会给我们带来更多的惊喜和机会。

2024-03-06

2024-03-06 阅读:2510

阅读:2510 来源:曲速超为

来源:曲速超为