2023年AI芯片领域重量级研发成果(Ⅰ)

< Google Amazon Microsoft Meta >

随着AI芯片领域的快速发展,各大公司之间的竞争也愈演愈烈,2023年,AI芯片领域呈现出了强劲的发展势头,全球各大公司纷纷投入巨资研发新的AI芯片,取得了不少重量级的研发成果。这一趋势不仅推动了AI技术的进步,也预示着AI芯片将成为未来科技领域的重要发展方向。在AI芯片的引领下,我们有理由相信,未来的科技世界将更加智能、高效和便捷。

下面就一起来回顾一下2023年AI芯片领域重量级的研发成果,由于篇幅较长,将会分三期进行梳理讲解,本期为第一期,将从Google、Amazon、Microsoft、Meta讲述其研发成果。

谷歌—TPU v5

2023年8月29日,美国旧金山Google Cloud Next '23大会上推出了新型AI芯片Cloud TPU v5e。

谷歌称客户可以使用单个Cloud TPU平台来运行大规模AI训练和推理。Cloud TPU v5e可扩展到数万个芯片,并针对效率进行了优化。与Cloud TPU v4相比,新版本每美元的训练性能提升2倍,推理性能提升2.5倍。TPU v5e提供与GKE、Vertex AI以及PyTorch、JAX和TensorFlow等领先框架的集成,客户可以通过易于使用、熟悉的界面开始使用。

2023年12月6日,谷歌官宣了全新的多模态大模型Gemini:our largest and most capable AI model.

针对三种不同尺寸对第一代Gemini 1.0进行了优化:

Gemini Ultra:最大、最强模型,适用于高度复杂的任务;

Gemini Pro:可扩展至各种任务的模型;

Gemini Nano:适用于端侧设备的高效版本;

据谷歌官网介绍,Gemini 1.0亮点主要包括五个方面:最先进的性能测试结果,新的推理以及创意功能,性能强大且高效的AI超算系统,责任与安全,以及可用性。

谷歌表示,在六项基准测试中,Gemini Pro性能表现优于GPT-3.5;而在30项性能基准测试中,Gemini Ultra超越了目前最强模型GPT-4。甚至,Gemini Ultra在MMLU测试上得分高达90.0%,在数学、物理、法律等57个领域测试中,Gemini Ultra成为第一个超越人类专家水平的AI模型。

同时,谷歌官宣了迄今为止功能最强大、效率最高且可扩展性最强的全新自研芯片 TPU v5p。

谷歌TPU v5p芯片采用台积电5nm/7nm工艺,相比前代TPUv4推理芯片,v5p更多是针对生成式 AI 所研发的训练芯片。每个TPU v5p pod(服务器组)都由8960个芯片组成,它通过TPU带宽最高的芯片间互连(ICI)以每秒4800Gbp速度在3D拓扑结构中连接。与TPU v4相比,TPU v5p的Flops性能提高了2倍以上,高带宽内存(HBM)增加了3倍。同时,TPU v5p训练大模型的速度比上一代TPU v4快2.8倍(280%),而借助第二代SparseCores,TPU v5p训练嵌入密集模型的速度比TPU v4快1.9倍以上。

Google 数据中心内一排 Cloud TPU v5p AI 加速器超级计算机

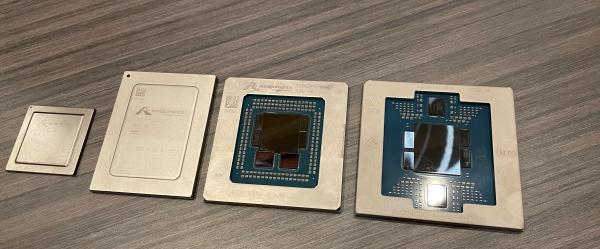

亚马逊—Trainium2

在11月26日-12月1日期间举办的2023亚马逊云科技re:Invent全球大会上,亚马逊云科技(AWS)推出了专为训练人工智能系统而设计的第二代芯片Trainium 2,以及通用Graviton 4处理器,为机器学习训练和生成式AI应用等广泛的工作负载提供更高性价比和能效。

Trainium2芯片采用了被动纠错方法,可将错误率降低100倍,即千分之一的错误率“0.1%”,而硬件过热现象相对预期减少6倍,相比于上一代Trainium1,Trainum2在速度上快出了4倍,同时在能效方面也有2倍的提升。

定制处理器芯片 Graviton4比前代性能提升30%,内核数增加50%,内存带宽增加75%,可以帮助Amazon EC2云服务的各类工作负载提供最佳性价比和能效。

Amazon Graviton4

Amazon Trainium2

据AWS计算和网络副总裁大卫•布朗介绍,Graviton比当时的可用产品计算性能提升了40%,Graviton 2比前一代提高了25%,Graviton 3比Graviton 2更优,现在Graviton 4至少比Graviton 3提高了30%。

从左至右依次为Graviton 1、Graviton 2、Graviton 3、Graviton 4

随着Trainium2的发布,亚马逊进一步巩固了其在量子计算领域的领先地位,Trainium2的推出将为量子计算技术注入新的动力,为各行各业提供更高效、更可靠的解决方案。

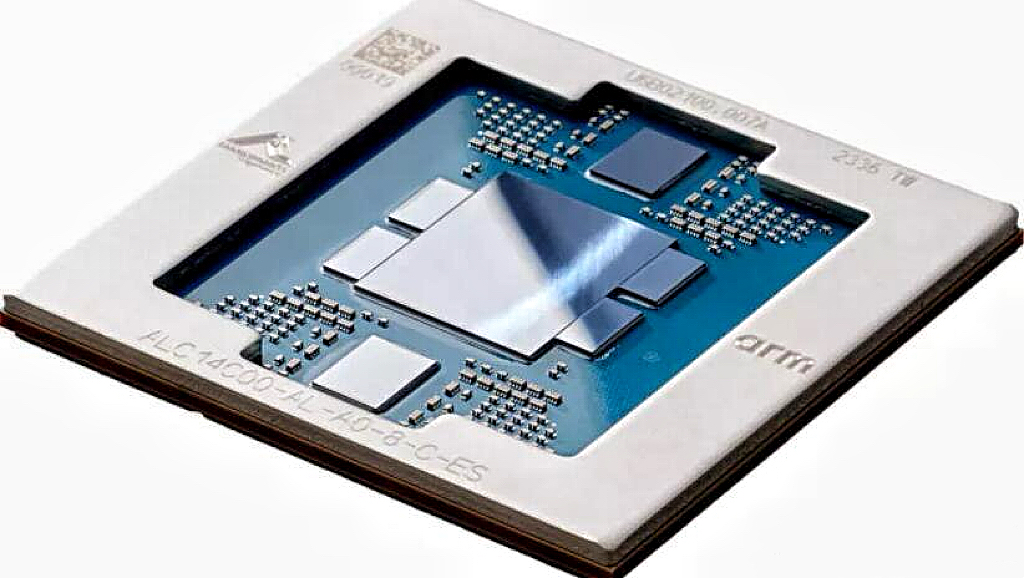

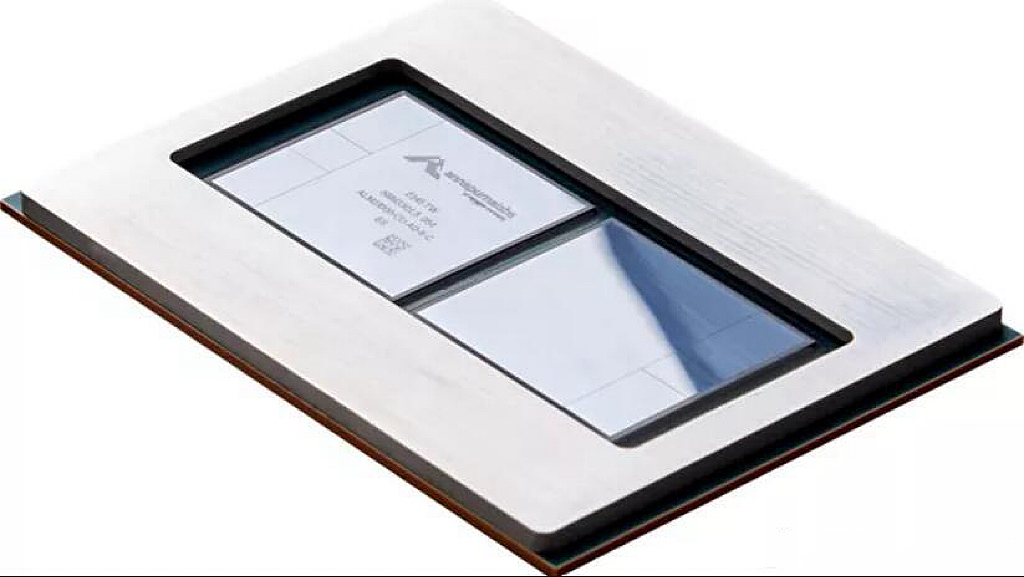

微软—Azure Maia 100

2023年11月16日,西雅图举行的 Ignite 开发者大会上,微软正式推出了两款自研 AI 芯片,用于强化 Azure AI 和 Microsoft Copilot 服务,分别为 Azure Maia 100 及 Azure Cobalt 100。

Maia 100的创新之处不仅在于其强大的性能,更在于其对Azure云服务的深度优化。这款芯片专门为Azure云服务而设计,能够更好地满足云端AI应用的需求,提供更高效、更可靠的服务。通过与Azure云服务的无缝对接,Maia 100能够实现更快速、更灵活的响应,为各种AI应用提供了更好的性能和体验。

Azure Cobalt 100是一款基于Arm芯片的服务器,专为在微软云上运行通用计算工作负载而设计。这款芯片的特点包括高密度、高可靠性、高安全性,适用于各种Web应用、数据库、容器和微服务等场景。它与Azure生态系统兼容,包括Azure Kubernetes Service、Azure Functions和Azure App Service等。

Azure Maia 100

Azure Cobalt 100

这两款芯片的发布填补了微软在芯片领域与谷歌、亚马逊等科技巨头之间的差距,使得微软在生态链的竞争中更加自给自足。这也表明了微软对于科技领域的持续投入和创新精神,为微软未来的发展奠定了坚实的基础。

Meta—MTIA

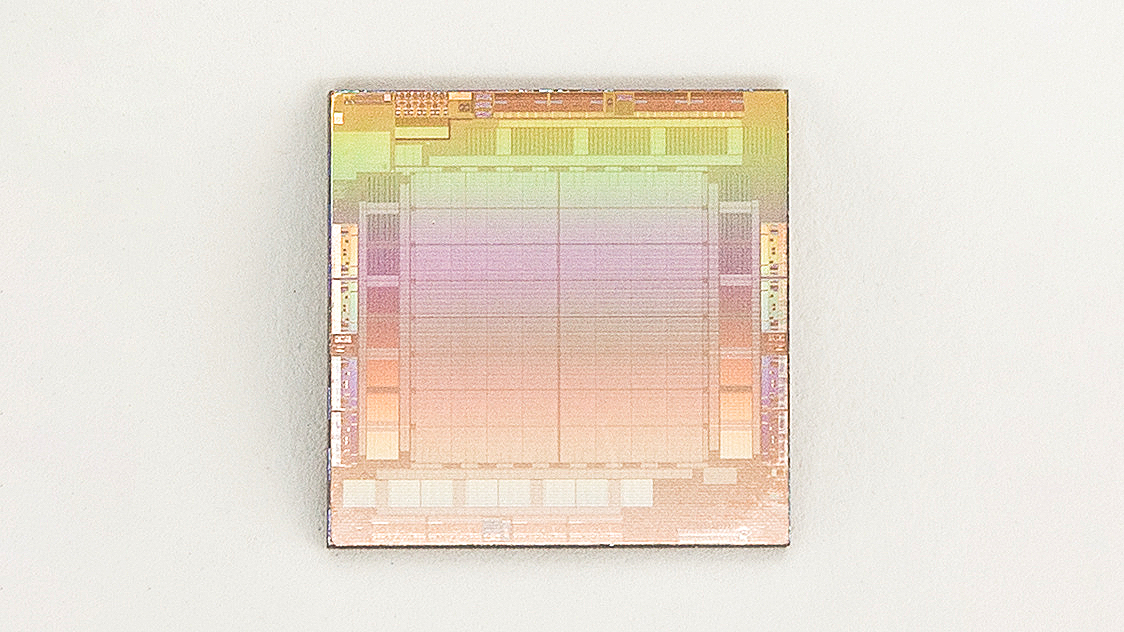

2023年5月19日,Meta公司首度公开其自研芯片的进展,表示开始计划开发一种用于训练人工智能模型的内部芯片,他们将这款新型芯片取名Meta训练和推理加速器,简称MTIA(MTIA v1),将其归类为加速人工智能训练和推理工作负载的“芯片家族”,并定计划于2025年推出。这种定制芯片采用开源芯片架构RISC-V,在类型上属于ASIC专用集成电路,Meta进行了高度定制化的设计。

早在2020年,Meta公司就开发了第一代基于7nm工艺的自研AI芯片MTIA,据其称,目前而言,MTIA的重点是针对Meta应用系列的“推荐工作量”上进行严格的推理,而不是训练。MTIA是一种ASIC芯片,它将不同的电路组合在一块板上,从而允许对其进行编程以并行执行一项或多项任务。其核心是一个由64个处理元件组成的网格,这些处理元件周围环绕着128 MB的SRAM内存,可用作主存储器或前端高速缓存。此外,它还配备了16个低功耗DDR5(LPDDR5)内存控制器,这为其提供了更高的数据传输速度和更低的功耗。MTIA v1推理芯片的出色性能得益于其先进的架构和优化的设计,它的处理元件网格和高速缓存可以同时处理大量的数据,从而提高推理速度和响应时间。它为Meta公司提供了强大的计算能力,使其能够更好地处理大规模的数据和复杂的推理任务。

首款自研AI芯片MTIA

有消息称,Meta除了MTIA之外,还在开发一款视频处理芯片,用于满足视频点播和直播流媒体的处理需求,不过,尽管这款芯片的开发已经取得了一定的进展,但要实现真正的商业化应用还需要经过一系列的测试和验证。我们期待Meta能够尽快推出这款新的视频处理芯片,为全球的用户带来更好的视频体验。

本期到这里就结束啦!

下期将讲述NVIDIA、AMD、Apple、Intel、Huawei等企业2023重量级研发成果!

敬请期待-2023年AI芯片领域重量级研发成果(Ⅱ)

2024-03-07

2024-03-07 阅读:1397

阅读:1397 来源:曲速超为

来源:曲速超为