2023年AI芯片领域重量级研发成果(Ⅱ)

< NVIDIA AMD Apple Intel Huawei >

在上期中,主要讲述了Google、Amazon、Microsoft、Meta四家领先企业的2023年重量级研发成果,从中我们可以意识到科技的快速发展,人工智能、大数据、云计算等新兴技术正在改变我们的生活与工作方式,未来的竞争可能会更加激烈与多元化。

本期为此系列第二期,将从通用计算类出发以NVIDIA、AMD、Apple、Intel、Huawei五家企业为例讲述其技术研发成果!

仔细往下阅读吧!

英伟达—H200

美国时间11月13日,英伟达在2023年全球超算大会(SC23),推出了新一代GPU H200。这款新的GPU基于H100进行了升级,内存带宽提高了1.4倍,内存容量提高了1.8倍,提高了处理生成式AI任务的能力。

英伟达NVIDIA H200 Tensor Core GPU以其卓越的性能和内存功能,正在改变游戏规则,为生成式AI和高性能计算(HPC)工作负载带来显著的提升。作为首款采用HBM3e技术的GPU,H200凭借更大、更快的内存,能够显著加速生成式AI和大型语言模型(LLM)的运行,推动HPC工作负载的科学计算。

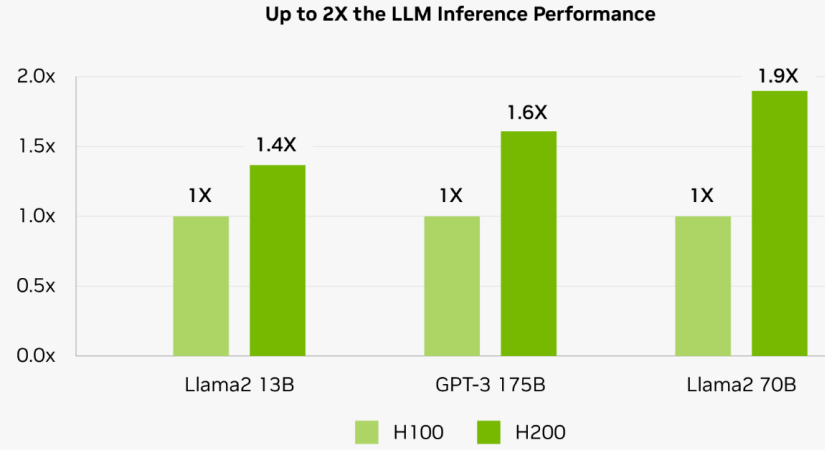

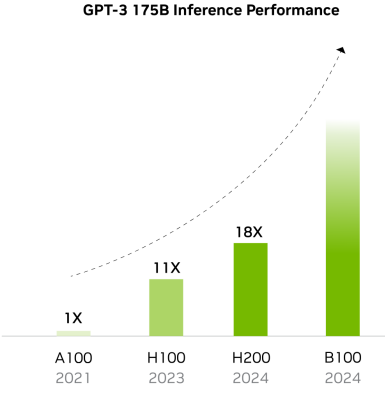

数据显示,在处理Llama2等LLM时,H200的推理速度比H100 GPU提高了近2倍;在GPT-3的推理表现中,H100的性能比A100提高了11倍,H200 Tensor Core GPU的性能比A100提高到了18倍。

官网信息显示,H200将于2024年第二季度开始向全球系统制造商和云服务提供商供货。有消息称,英伟达将在未来几个月内继续增强AI性能,2024年预计发布的新一代旗舰AI芯片B100将继续突破性能与效率的极限。

美国超威半导体公司(AMD)—Instinct MI300X

2023年12月6日,美国超威半导体公司(AMD)举行“Advancing AI”发布会,并宣布推出AI芯片AMD Instinct MI300X GPU。

MI300X是一个纯GPU版本,采用AMD CDNA 3技术,使用多达192GB的HBM3高带宽内存来加速大型语言模型和生成式AI计算。相比上一代MI250X,MI300X增加了近40%的计算单元、1.5倍的内存容量、1.7倍的峰值理论内存带宽,并支持FP8和稀疏性等新数值格式。这款全新AI芯片舍弃了APU的24个Zen内核和I/O芯片,转而采用更多的CDNA 3 GPU和更大的192GB HBM3,提供5.2 TB/s的内存带宽和896GB/s的Infinity Fabric互连带宽。MI300X的HBM密度是英伟达H100的2.4倍,带宽是英伟达H100的1.6倍,这意味着AMD可以运行比英伟达芯片更大的模型。

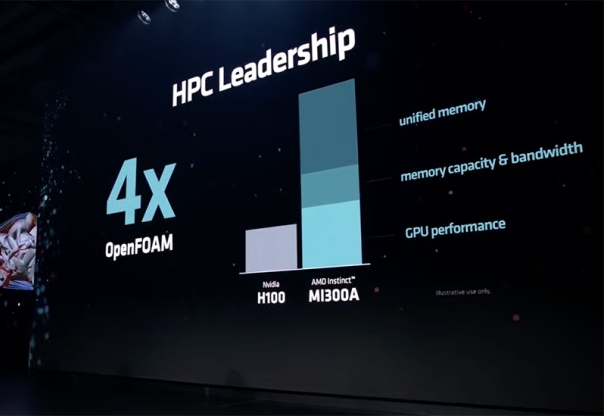

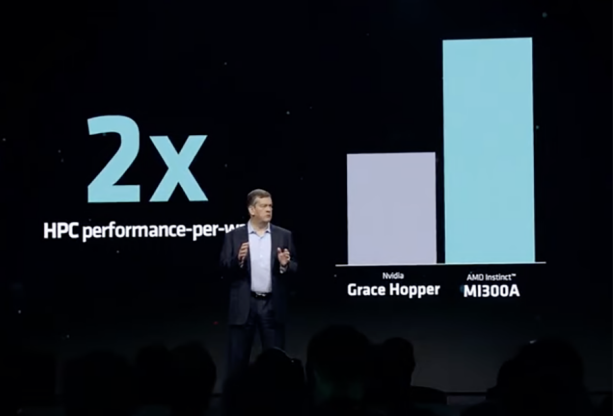

除了MI300X外,AMD还宣布推出结合最新AMD CDNA 3架构和“Zen 4”CPU的MI300A加速处理单元(APU),是世界上第一个用于HPC和AI的数据中心APU。MI300A在FP32 HPC和AI工作负载上提供了约1.9倍的每瓦性能,与MI250X相比,其性能优势明显。和英伟达H100 SXM相比,MI300A的内存容量、峰值内存带宽、FP64精度HPC矩阵及向量峰值性能均更高。通过将统一内存、内存带宽、GPU性能多重优势组合,MI300A在OpenFOAM高性能计算MotorBike测试中,得分是H100的4倍。在PeakHPC每瓦性能测试中,MI300A的成绩是英伟达GH200的2倍。在跑多种高性能计算任务时,相比H100,AMD MI300A均略胜一筹。总的来说,AMD MI300A是一款强大的加速处理单元,适用于各种高性能计算和人工智能应用场景。

AMD称,戴尔、惠普、联想、Meta、微软、甲骨文、Supermicro等公司均会采用MI300系列产品。其中,微软与AMD合作推出新的Azure ND MI300x v5虚拟机(VM) 系列,该系列针对 AI 工作负载进行了优化,并由MI300X提供支持;Meta公司将在数据中心采用AMD新推的MI300X芯片产品。甲骨文表示,公司将在云服务中采用AMD的新款芯片,预计将在2024年发布。

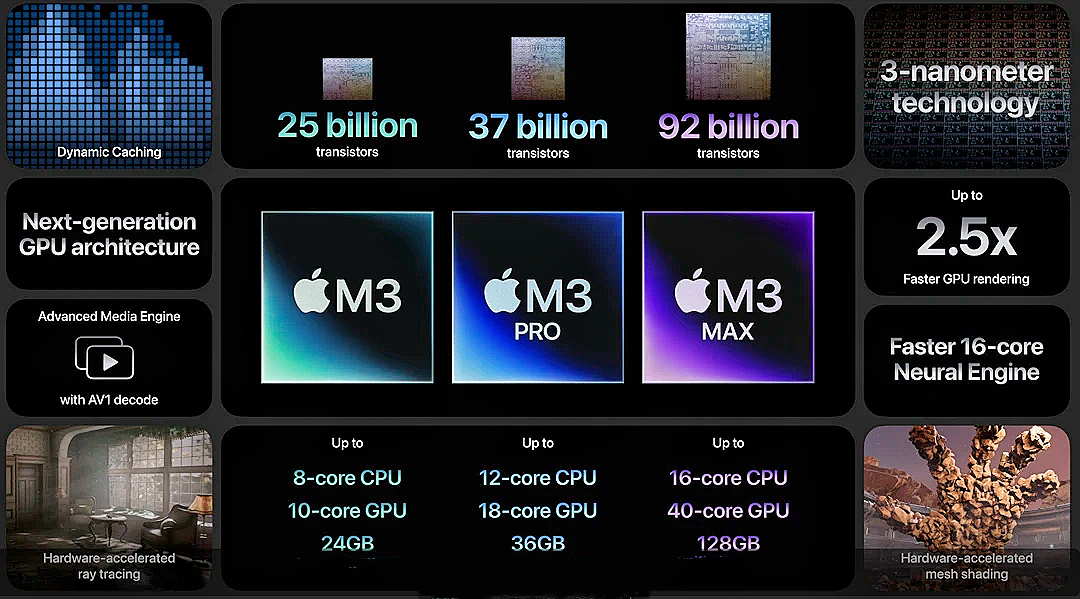

苹果—M3系列

2023年10月31日,苹果公司发布了第三代高端旗舰芯片M3系列:M3、M3 Pro和M3 Max。M3系列芯片采用了3纳米工艺制程,搭载的新一代图形处理器实现了Apple芯片史上最大幅的图形处理器架构飞跃,还引入一项全新技术——动态缓存,同时带来首次登陆Mac的硬件加速光线追踪和网格着色等全新渲染功能。

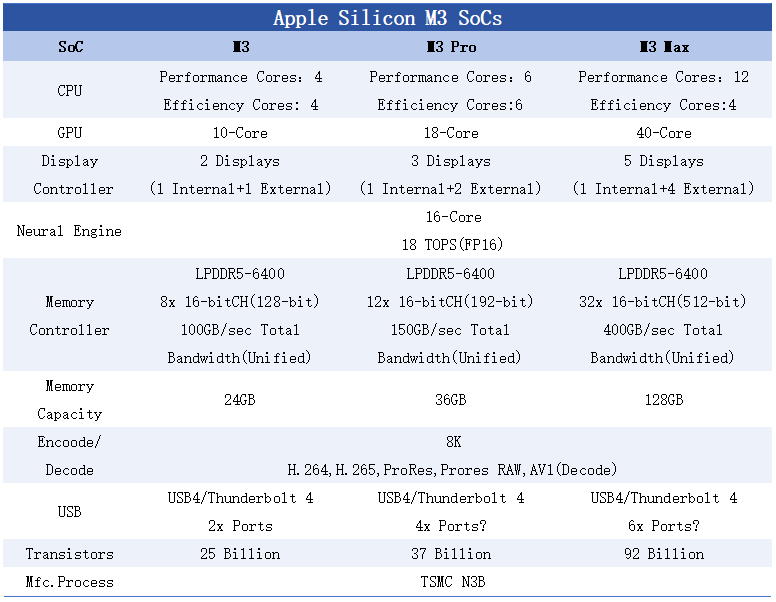

下表为M3系列芯片参数规格表:

M3芯片:搭载250亿个晶体管和新一代架构的10核图形处理器,8核中央处理器包含4个性能核心和4个能效核心,支持最高可达24GB的统一内存。

M3 Pro芯片:搭载370亿个晶体管和18核图形处理器,12核中央处理器包含6个性能核心和6个能效核心,支持最高可达36GB的统一内存。

M3 Max芯片:搭载920亿个晶体管和40核图形处理器,16核中央处理器包含12个性能核心和4个能效核心,支持最高可达128GB的统一内存。

三款芯片均支持H.264、H.265、HEVC、ProRes和ProRes RAW硬件加速,还首次支持AV1解码。

总的来看,CPU方面,M3的性能核心相较于M1提升30%,能效核心相较M1最高可提升50%,保持了出色的能耗比,当性能与M1相当时,其功耗仅为M1的一半,而在GPU方面,当性能与M1相同时,功耗也基本只有一半。这意味着在处理任务时,新款处理器不仅性能更强大,而且更加节能。

对比上一代产品,M3系列芯片的出色性能表现不仅使其在市场上更具竞争力,同时也为用户带来了更好的使用体验。无论是日常使用、娱乐应用还是专业工作方面,M3系列芯片都能为用户带来更快速、更高效的处理能力,从而大大提升用户的满意度。

伴随着技术的进步和市场需求的增强,M3系列芯片的独特优势使得它们更为与众不同,我们有理由相信M3系列芯片将会成为未来电脑芯片领域的新宠,期待苹果公司进一步推进芯片技术的开发,为用户带来更加卓越的性能与应用体验。

英特尔—Gaudi2

2023年7月,英特尔AI产品战略暨Gaudi2新品发布会举行,正式向中国市场推出第二代Gaudi深度学习加速器——Habana® Gaudi®2。

Gaudi2包括24个可编程Tensor处理器核心(TPCs)、21个100Gbps(RoCEv2)以太网接口、96GB HBM2E内存容量、2.4TB/秒的总内存带宽、48MB片上SRAM、集成多媒体处理引擎,能够满足各种高端应用的需求,为高性能计算、网络和多媒体应用提供了强大的支持。

与其他面向大规模生成式AI和大语言模型的产品相比,Gaudi2在性能上表现卓越,尤其在与A100等高端GPU竞争中,Gaudi2的优势更加明显。而且,在各种最先进的模型上,Gaudi2的性能相对于A100提升了约2倍,这意味着在性价比方面,Gaudi2具有显著优势。

英特尔发布的Gaudi2新品是中国特供产品,它的推出特别考虑到中国市场,具有针对出口和支持中国客户的独特解决方案。这款中国版产品在性能上与原版Gaudi2相比,两者之间几乎没有差别。而且,针对中国市场的需求,它删减了集成以太网端口的数量,从原来的24个端口减少到21个。值得一提的是,Gaudi2及其后续产品Gaudi3都将继续在合法合规的情况下,为中国客户提供支持。英特尔对中国的长期承诺和承诺将继续得到维护,我们将继续期待他们在未来带来更多优秀的产品和服务。

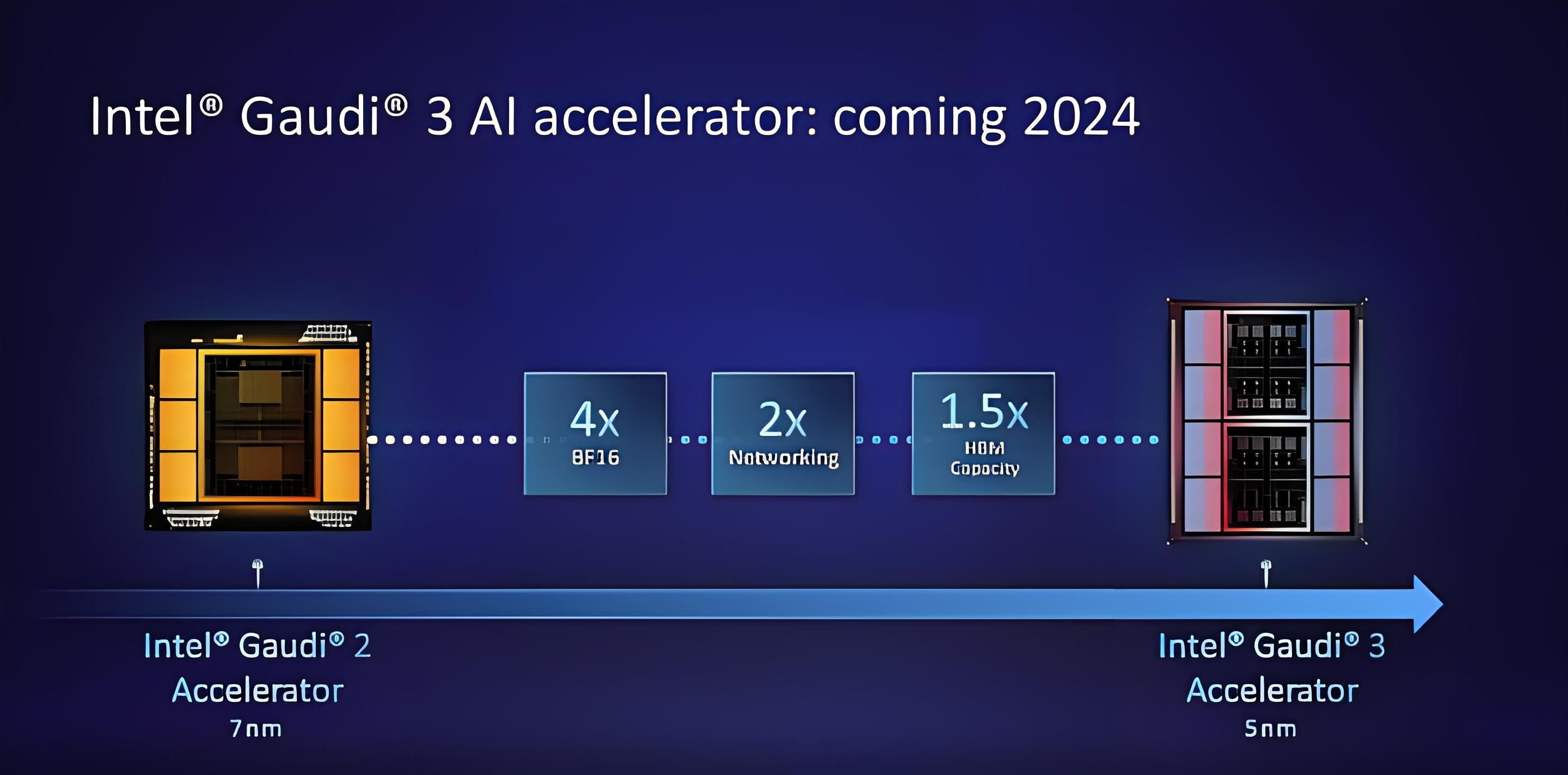

英特尔在11月举办的SC23大会上,透露了将在2024年发布Gaudi3,称Gaudi3采用5nm工艺,带宽是前代Gaudi2(7nm工艺)的1.5倍,BF16功率是其4倍,网络算力是其2倍,配备最高128GB的HBM3eRAM,大幅提升AI学习和训练性能,让我们拭目以待。

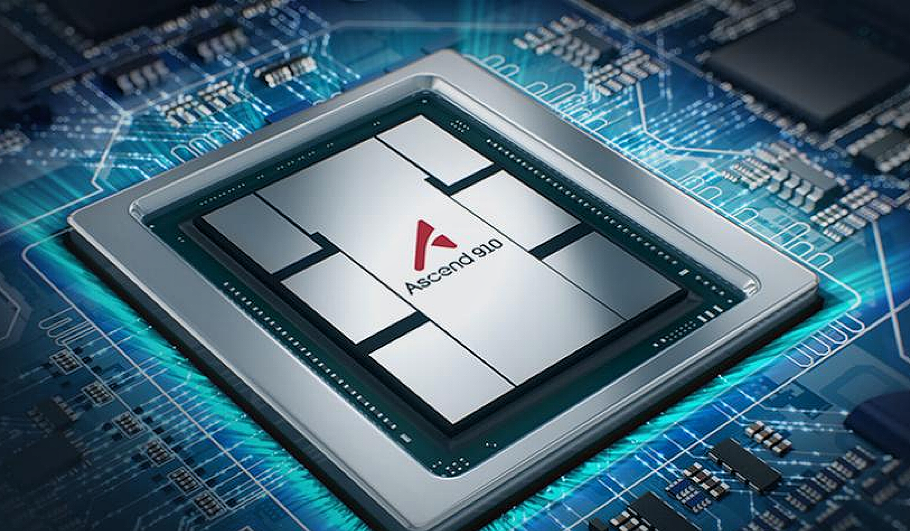

华为—昇腾910B

美国为了保持其在AI领域的领先地位,限制了英伟达和AMD公司的高端GPU芯片对中国的销售,其目的就是为了迟滞中国在人工智能领域的发展,这意味着中国企业在使用高性能计算、人工智能等需要大量计算能力的领域时,将面临更严峻的挑战。在华为昇腾的世界里,一款名为昇腾910B的全新产品横空出世,吸引了众多关注,它不仅仅是一款芯片,更是华为在人工智能领域的新突破。

随着华为昇腾910B的出现,它的强大性能引起了广泛的关注和讨论,首要亮点在于其极强的高性能计算能力,它采用了最新的7nm工艺制造,基于自研达芬奇架构,拥有256个AI计算核心,峰值算力高达376TFLOPS,配备64GB内存,功耗为400W,据悉,该芯片性能基本可对标英伟达 A100。随着人工智能和大数据技术的发展,计算能力的重要性日益凸显而华为昇腾910B的出世无疑为未来的计算领域发展提供了新的可能性和方向。

自2020年以来,华为一直与百度深度合作,而此次百度也首当其冲为200台服务器订购了1600颗华为昇腾910B芯片,到2023年年底,华为已获中国企业预购至少5000颗昇腾910B芯片,预计在2024年开始交货。

据华为消息称,昇腾910B可以使得人工智能在各领域的应用展现更多新的可能,广泛应用于科学研究、医疗诊断、智能交通、智能家居等涵盖了多个领域,将为人们的生活带来颠覆性的改变与更多的便利,它的强大性能和广泛应用前景,将为整个行业带来巨大的影响和变革。

昇腾910B的出世启示着我们‘科技是无法被阻挡的’,无论未来有多少困难,我们都要相信科技创新的力量,不断地追求更高的可能性才能在困境中找到突破口,这不仅是对我们自身的挑战也是对全球科技领域的挑战。

本期到这里就结束啦!

希望大家都有豁然开朗的感觉!

最后一期将讲述Qualcomm、MTK、Apple、Huawei等企业2023在移动端芯片领域重量级研发成果!

敬请期待-2023年AI芯片领域重量级研发成果(Ⅲ)

2024-03-07

2024-03-07 阅读:1252

阅读:1252 来源:曲速超为

来源:曲速超为