生成式AI作为其中的一颗璀璨明珠,以其独特的魅力引领着学术与科技的创新浪潮。从文本生成到图像、音频、视频的自动生成,其应用范围日益广泛,这些技术的结合,为我们打开了一个充满无限创意的世界。

文本生成让机器拥有了“说话”的能力,它们可以像人类一样流畅地表达思想,撰写文章,甚至创作诗歌和小说,不仅极大地丰富了我们的文化生活,还为信息传播、智能客服等领域带来了革命性的变革。

图像生成技术则让机器成为了“画家”和“摄影师”。通过深度学习和神经网络模型,机器可以从海量的图像数据中提取特征,生成逼真的新图像。无论是风景、人物还是抽象艺术,都能为我们呈现出别具一格的视觉盛宴。

音频生成和视频生成技术的崛起,更是让机器具备了“歌唱”和“演绎”的能力。无论是优美的旋律,还是震撼的影像,都能为我们带来前所未有的视听体验。

人工智能已成为对传统领域进行数字化转型的重要技术手段,本文将从生成式AI技术入手,总体概述文本生成、图像生成、视频生成、音频生成技术并以例说明。

文本生成

文本生成是自然语言处理中一个重要的研究领域。自然语言生成系统定义为接受非语言形式的信息作为输入,生成可读的文字表述,即文本生成技术,包括了文本到文本的生成、数据到文本的生成、图像到文本的生成。

文本生成的核心主要包括:语言模型、上下文理解、序列生成、控制机制。

文本生成的核心算法包括:统计语言模型如HMM;神经网络语言模型如NNLM;生成模型如GAN、VAE;

近年来,大型预训练模型如GPT、BERT等已成为自然语言处理领域的标准模型,它们在多种任务上都展现出卓越的性能,尤其在文本生成任务上。

在这个信息爆炸的时代,自然语言处理技术已成为我们获取、理解和利用信息的关键工具。作为目前最流行的预训练语言模型之一,ChatGPT凭借其卓越的性能和广泛的应用场景,正在引领着自然语言处理的新潮流。ChatGPT不仅能在文本分类、情感分析等传统任务中展现出强大的实力,更能在文本生成领域大放异彩。无论是创作优美的诗歌、撰写深入的评论文章,还是生成有趣的对话,ChatGPT都能凭借其深度学习和理解的能力,为我们提供丰富、多样且富有创意的输出。

图像生成

图像生成是计算机视觉领域的一个重要方向,涉及到从高级描述符(如文本、音频、图像)生成低级描述符(图像、视频、语音)。图像生成技术广泛应用于虚拟现实、游戏、机器人、自动驾驶等领域。

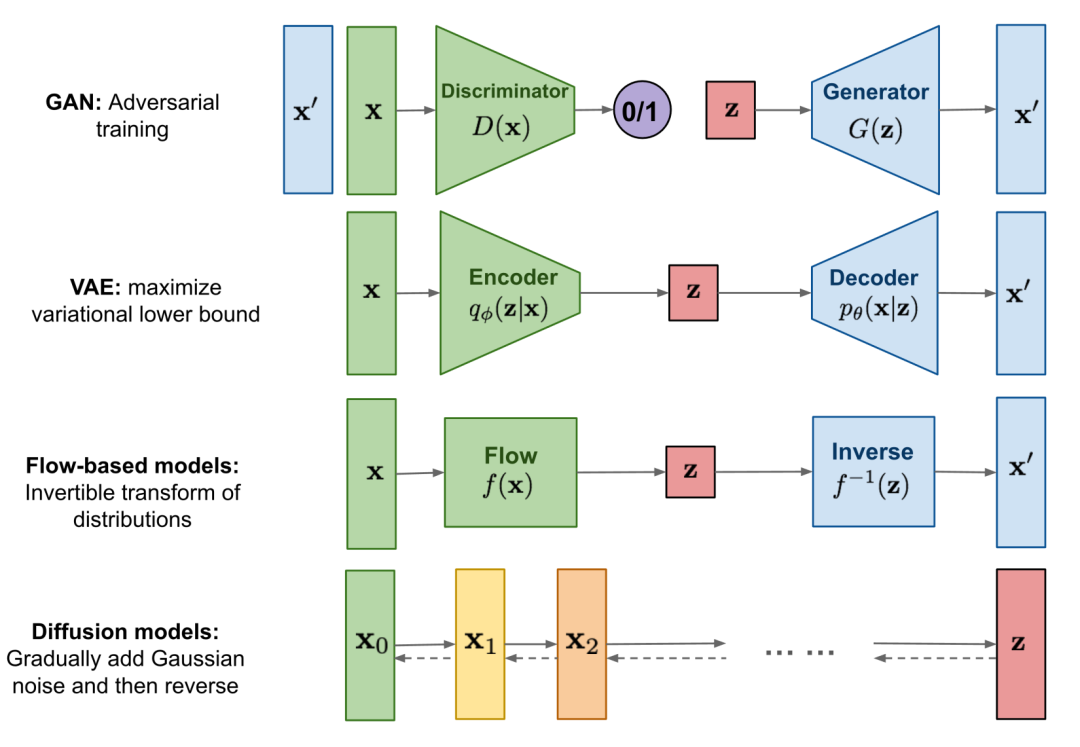

图像生成的技术框架主要包括生成式对抗网络(GAN)、变分自编码器(VAE)、扩散模型(Diffusion)等,其中主流模型为扩散模型。

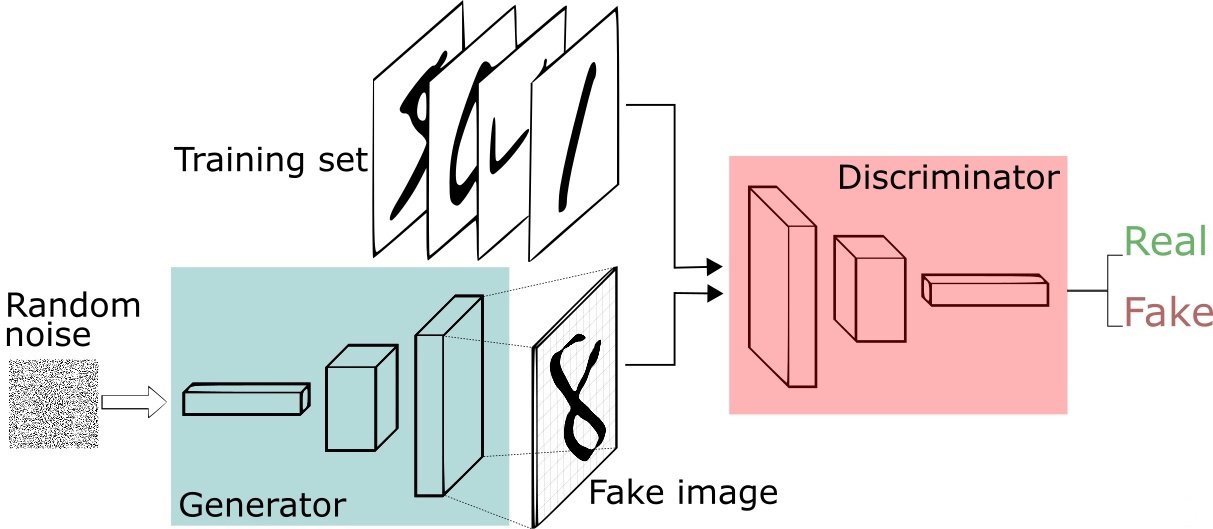

生成式对抗网络-GAN

在扩散模型成为主流模型之前,GAN是主流模型,通过生成器和判别器进行对抗训练来提升图像生成能力和鉴别能力,从而使数据更接近真实数据,图像更接近真实图像。相较于其他模型,GAN的参数更小更轻便,更擅长对单个或者多个对象类进行建模,但由于训练过程的不确定性,面对复杂数据极具挑战性,不稳定性,生成的图片缺乏多样性,以致最终被其他模型所取代。

GAN架构由两个主要网络组成:

1. 生成器(Generator):负责从随机噪声中学习生成与真实数据相似的数据。

2. 判别器(Discriminator):尝试区分生成的数据和真实数据。

下图是GAN的架构

这两个组件在训练过程中相互对抗,共同提升,最终目标是使生成器能够生成与真实数据难以区分的新数据。

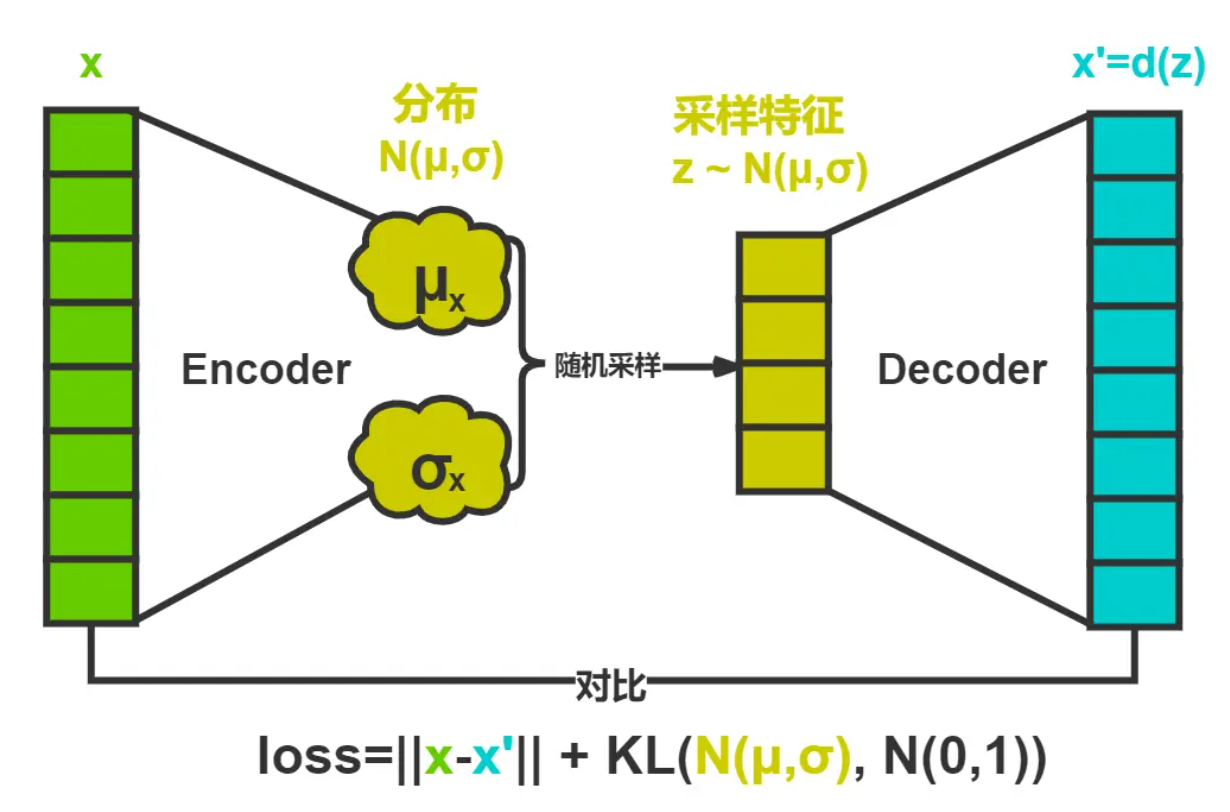

变分自编码器-VAE

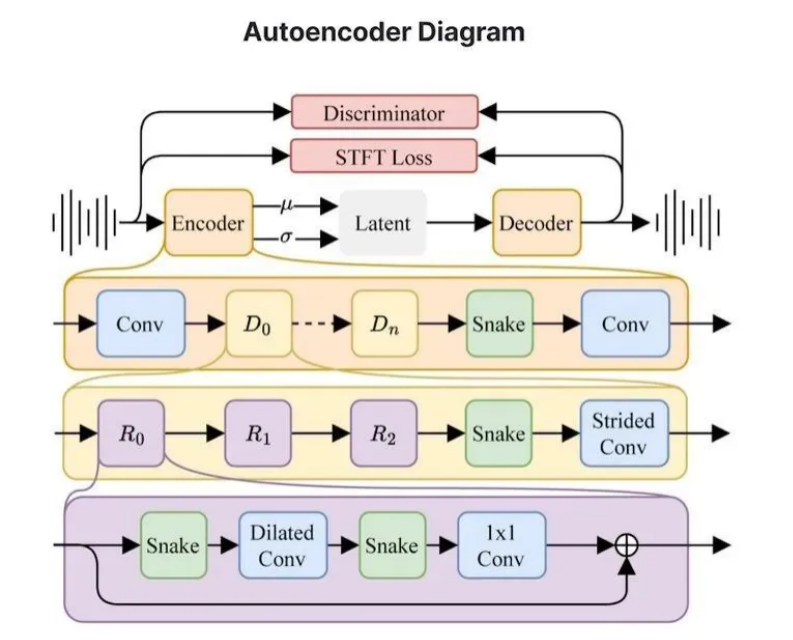

在了解变分自编码器之前,先来了解一下自编码器(Auto-Encoders),它的思路十分简单,其组件包括编码器和解码器,编码器和解码器大多是神经网络,并使用迭代优化学习最优的编码-解码方式。在每次迭代中,我们将经过“编码—解码”的输出与初始数据进行比较,并通过反向传播来更新网络的权重。整个自编码器结构会构造出数据瓶颈,需要确保关键信息可以通过瓶颈并进行重构。自编码器结构仅以尽可能少的损失为目标进行训练,缺无所谓隐空间的组织形式,因此网络会利用过拟合可能性来完成学习任务。

VAE包含两个部分:编码器encoder和解码器decoder。编码器将原始数据映射到潜在空间,解码器则将潜在空间中的数据进行编码和解码,从而实现从潜在空间生成原始数据的目标。

变分自编码器(VAE)同样是自编码器结构,它通过使编码器返回隐空间中的分布而不是单个点,并在损失函数中添加一个对返回的分布的正则项来解决隐空间不规则性的问题,以确保更好地组织隐空间。

扩散模型-Diffusion

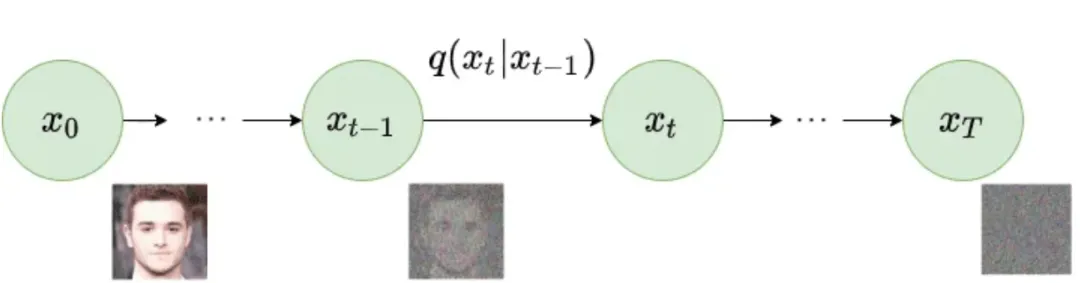

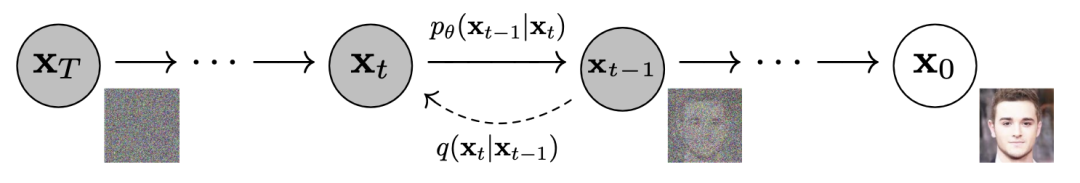

扩散模型是一种先进的机器学习算法,它们通过逐步向数据集中添加噪声,然后学习如何逆转这一过程,独特地生成高质量数据。这种方法使它们能够创造出非常精确和详细的输出,从逼真的图像到连贯的文本序列,它们的核心功能是逐渐降低数据质量,在将其重建为原始形态或是新的东西。

扩散模型包括两个过程:前向过程和反向过程,其中前向过程又称为为扩散过程,无论是前向过程还是反向过程都是一个参数化的马尔可夫链,其中反向过程可以用来生成数据。

正向扩散过程:

起始点是原始数据,这可以是任何类型的数据,如图像、文本或音频等。在这一步中,通过一个马尔科夫链,逐步向原始数据添加高斯噪声,这个过程分成多个小步骤,每一步都以一种确定性的方式向数据中添加噪声。经过足够多的步骤后,原始数据几乎完全转化为随机噪声,形成一个与原数据几乎毫无关系的噪声图像。

反向扩散过程:

起点是一个噪声数据,这个噪声数据是通过前向扩散过程得到的纯噪声图像。在这一步中,通过一个深度学习模型(通常是卷积神经网络),逐步去除噪声。这个模型被训练来预测正向过程中加入噪声的逆过程,即如何从噪声图像中逐步恢复出原始数据。通过逐步减少噪声,可以恢复到与原始数据相似的图像,或者根据训练生成新的数据实例。这个过程是高度非线性的,需要大量的计算资源。

下图为扩散模型与其它主流生成模型的对比:

目前市场上流行的Diffusion工具有Stable Diffusion、DALLE2、DALLE3等,详细介绍可参考上篇文章第二部分。

(上篇文章中有GPT与图像生成的相关资料可供参考,这里做简单说明)

视频生成

视频生成是通过对人工智能的训练,使其能够根据给定的文本、图像、视频等单模态或多模态数据,自动生成符合描述的、高保真的视频内容。当前主要可分为文生视频、图生视频、视频生视频。视频生成与图像生成底层架构类似,主要为生成式对抗网络(GAN)、自回归模型(Transformer)、扩散模型(Diffusion)三大类,可参考图像生成部分叙述。

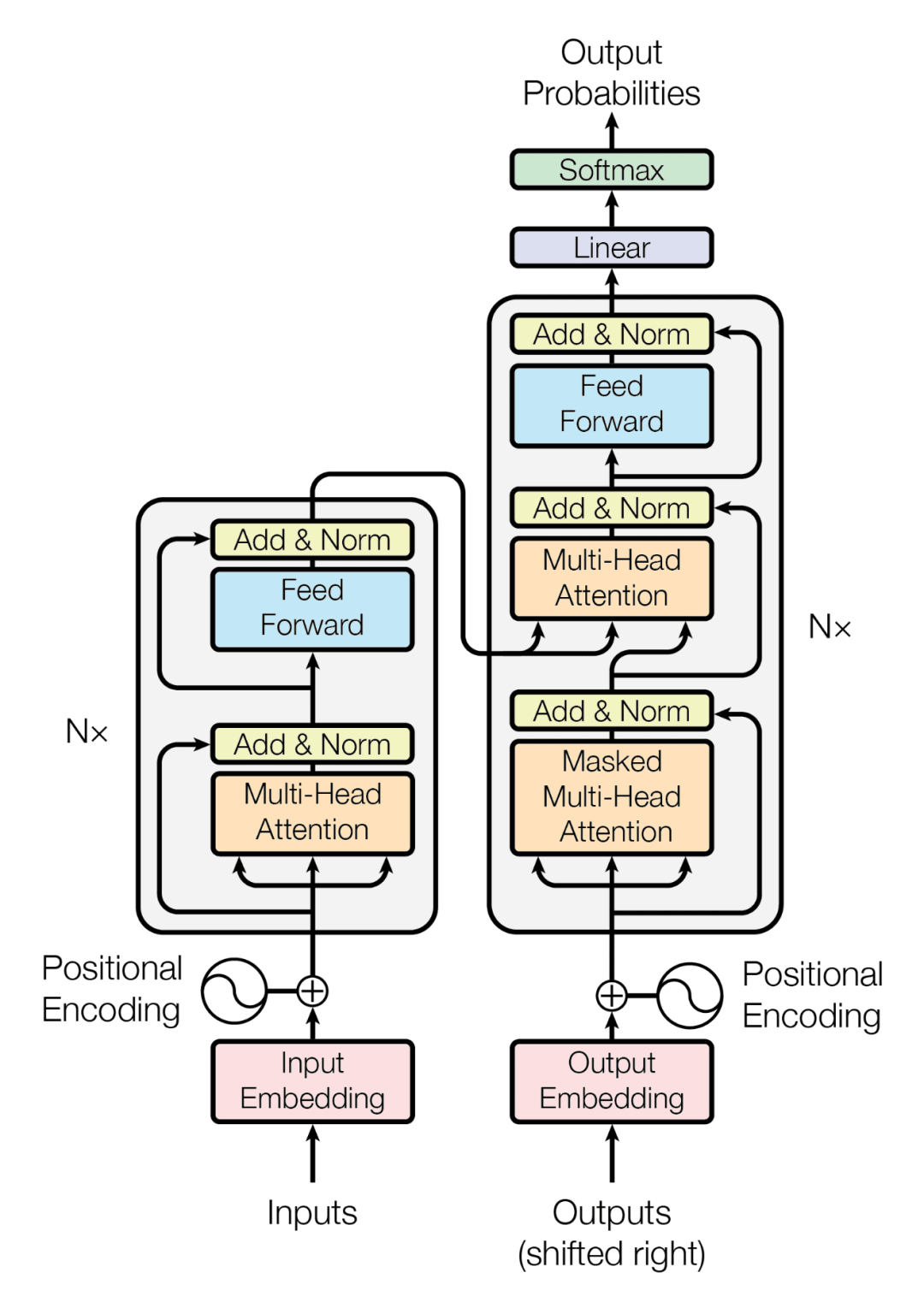

自回归模型-Transformer

自回归模型具有明确的密度建模和稳定的训练优势,可以通过帧与帧之间的联系,生成更为连贯且自然视频。

Transformer整体框架主要分为Encoder(编码)和Decoder(解码)两部分,最初由Google在2017年提出。Transformer是一种基于自注意力机制的模型,可以在输入序列中进行全局信息的交互与计算,从而获得比传统循环神经网络更好的长距离依赖建模能力。

下图为Transformer工作流程示意图:

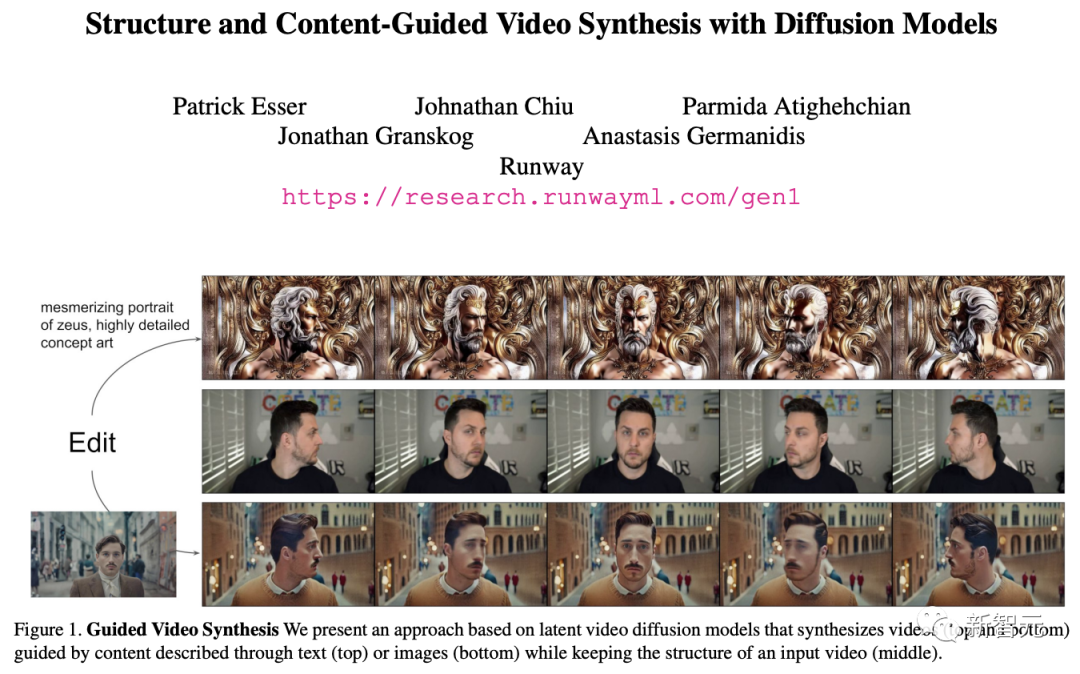

这里以Runway 、Sora、Pika为例,Sora的具体介绍可以参考之前的文章;

Runway基础模型是一种基于深度学习的视频生成模型,通过学习和理解视频数据,生成高质量的视频内容。

Gen-1,以视频生成视频以其多功能性文明,用于广泛的艺术与设计项目;

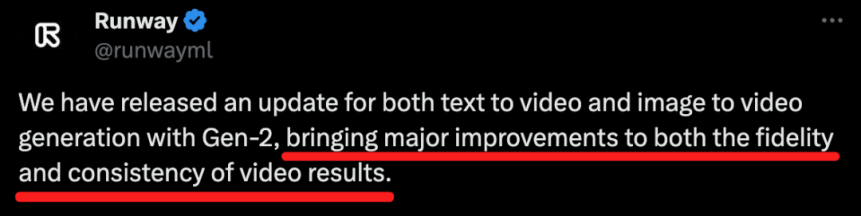

Gen-2,二代,以文本描述、图像、视频剪辑生成视频,聚集了1代的功能,且细节的一致性达到了前所未有的水平,代表多模态的AI进入了新阶段。更新特点:在文生视频和图生视频中,为结果的保真度和一致性带来了重大改进。

在Sora上线以前,Pika一直都是Runway Gen-2的最强竞品,2023年11月,Pika Labs发布了第一个产品Pika 1.0,它能够能够生成和编辑各种风格的视频,如动漫、动画、电影等,相比同类工具,风格多样、高效易用、实时预览、高质量输出是它最为突出的特点。Pika提供了个性化与模版选择,实时处理能力非常强悍。

音频生成

以Pika、Stable Audio为例:

Pika 1.0上线之后,经过几个月时间的沉淀,Pika Labs又放出一个大招,给视频‘make some noise’,没错,Sound Effects功能它可以给视频无缝生成音效,同时有两种生成方式,一种是描述一种你想要的声音给一句Prompt;一种是Pika根据视频内容自动生成。

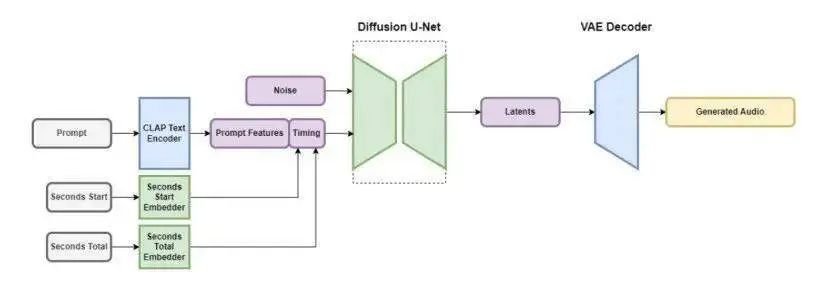

Stable Audio是一款基于文本的音频生成工具,通过文本提示快速生成高品质(达到44.1kHz)的音乐与音效。该模型包括一个文本编码器和一个基于U-Net的条件扩散模型,使用内存高效的注意力实现来有效地扩展到更长的序列长度。Stability AI使用领先的音乐库AudioSparx提供的数据集来训练Stable Audio模型,该数据集的多样性增加了生成音频的稳健性和多功能性。

Stable Audio 2.0尤其令人瞩目的是其独特的自然语言驱动功能,通过几句语言的提示,就能完整生成约三分钟的高品质立体声音乐作品,具备完整的连贯音乐结构,并且还能进行音频向音频的转换,让创作变得更加多元与个性化。

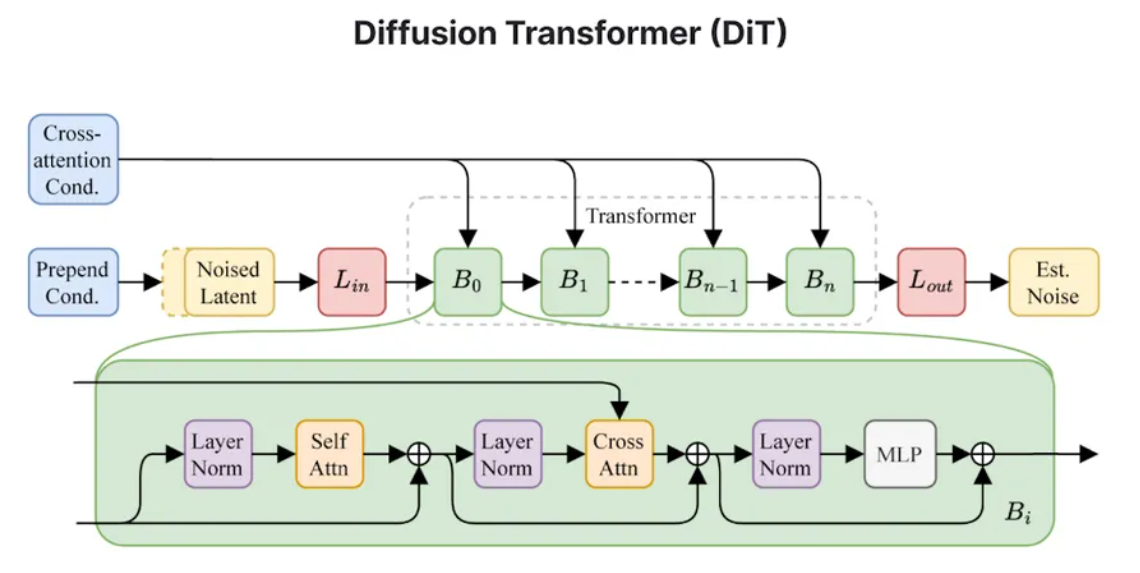

在技术方面,Stable Audio 2.0采用潜在扩散模型构架,能够生成具有连贯结构的完整音轨,而扩散模型采用类似于Stable Diffusion 3中使用的Diffusion Transformer(DiT)来代替之前的U-net,更擅长处理长序列的数据,能够准确捕捉并复现高质量音乐作品中的复杂大规模结构。

与1.0相比,2.0不仅承袭了一代的各项优势,更在多维度实现了技术创新与性能优化,引入的音频到音频转化特性亦是其一大亮点,用户现可上传任意音频素材,并通过自然语言引导将其转化为丰富的音效表现。

Stable Audio 2.0的现世,代表着Stability AI在音乐科技创新领域的重要里程碑,同时也预示着全球音乐科技产业即将迎来一场新的变革。音乐创作的新未来已然触手可及,在人工智能技术深度渗透的新时代,每一位都有机会成为音乐世界的塑造者,共同见证并投身于音乐产业蓬勃发展的辉煌旅程。

生成性AI技术的日新月异,其非凡的潜力已经远远超出了我们最初的设想。不仅在传统行业中大放异彩,更在经济和社会领域引领着一场深刻的变革,各大公司纷纷调整对生成性AI未来的预测,它可能比我们预想的更早地承担更多工作。这一技术的发展速度之快、应用范围之广令人惊叹。从简单的重复性任务到复杂的决策分析,生成性AI技术正逐渐渗透到我们生活的方方面面,不仅提高了工作效率,更在推动着整个社会的创新和进步。我们正站在一个全新的起点上,期待着生成性AI技术继续书写更加辉煌的未来篇章。

参考资料:

[1]https://blog.csdn.net/universsky2015/article/details/136013608

[2]https://blog.csdn.net/weixin_43612023/article/details/98047096

[3]http://www.yuqingqi.com/article/detail/id/62454.html

[4]https://cloud.baidu.com/article/3181462

[5]https://research.runwayml.com/introducing-general-world-models

[6]https://mp.weixin.qq.com/s/WgSD3kOGQBSo9OEE7JxNCA

[7]https://stability.ai/news/stable-audio-2-0

[8]https://www.163.com/dy/article/IV1D97UB0511PEBT.html

[9]https://mp.weixin.qq.com/s/lCAliF7qEjhJFtYWKZIGSg

[10]https://mp.weixin.qq.com/s/-LuiirPB9Q_WvRaqGdawtw

2024-05-07

2024-05-07 阅读:1309

阅读:1309 来源:曲速超为

来源:曲速超为